OpenAI se sinceró, por primera vez, sobre el número de usuarios de ChatGPT que muestran signos de crisis mental

Leer más: ChatGPT Atlas, el nuevo navegador que competirá con Google

En los últimos meses, varios medios de Estados Unidos han reseñado casos donde personas terminan muertas tras sostener intensas conversaciones con el chatbot.

Algunos familiares de las víctimas responsabilizan a la compañía de “alimentar” los delirios y paranoias a través de la plataforma.

La situación ha escalado a tal punto, que algunos profesionales de psicología y psiquiatría han tildado el fenómeno como “psicosis por IA”.

Usuarios con psicosis, manía y posibles pensamientos suicidas

Recientemente, la compañía creadora de ChatGPT, divulgó un informe sobre la estimación de usuarios que utilizan la plataforma en todo el mundo y que pueden presentar signos de crisis mental.

En el texto, OpenAI estimó que alrededor del 0.07 % de los usuarios activos de ChatGPT muestran posibles signos de emergencias de salud mental relacionadas con la psicosis o la manía.

Mientras que el 0.15 % tienen conversaciones que incluyen indicadores explícitos de posibles planes o intenciones suicidas. Es decir, al menos 1,2 millones de usuarios.

Asimismo, reveló que hay una proporción de usuarios que parecen depender en exceso del chatbot. A juicio de la empresa, alrededor del 0.15 % muestran un elevado nivel de apego emocional con ChatGPT.

Actualizaciones sin garantía

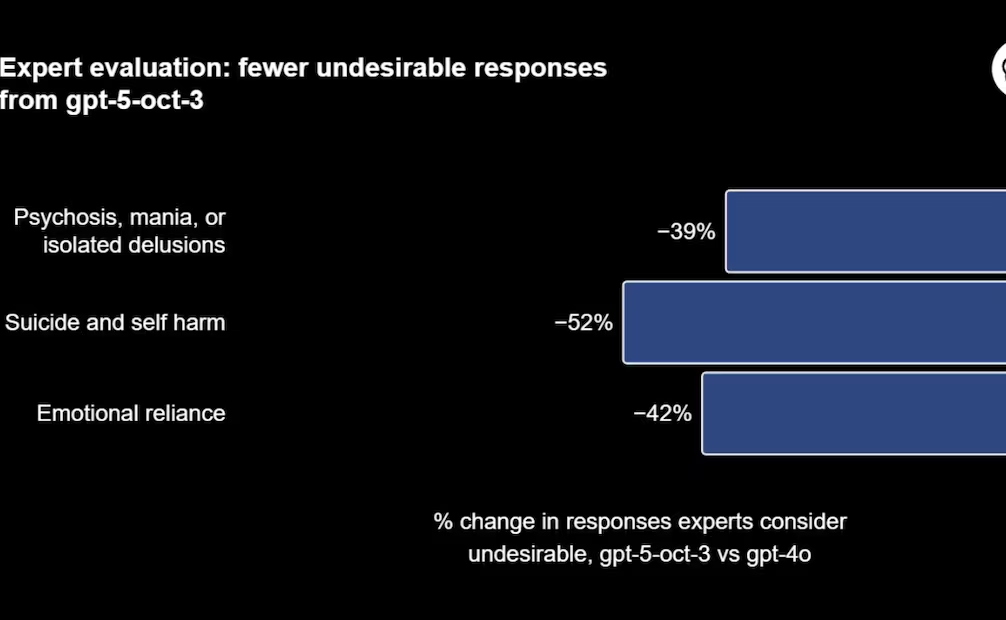

OpenAI explicó que expertos médicos revisaron más de 1,800 respuestas relacionadas con posibles psicosis, suicidio y apego emocional y compararon las respuestas de la última versión de GPT-5 con las producidas por GPT-4o.

Debido a estos resultados, la empresa mencionó que está actualizando el chatbot para que pueda reconocer con fiabilidad los indicadores de angustia mental. Tras detectarlos, podrá guiar a los usuarios a buscar ayuda en el mundo real.

OpenAI dijo que se encuentra trabajando con más de 170 psiquiatras, psicólogos y médicos de atención primaria. Con sus conocimientos, la empresa planea mejorar la forma en que ChatGPT responde en conversaciones que implican riesgos graves para la salud mental.

No obstante, los mismos expertos creen que a pesar las mejoras, no hay forma de saber si los usuarios con este tipo de problemas buscarán ayuda o cambiarán su comportamiento.

Fuente: Wired